AMD и Qualcomm бросают вызов Nvidia, предлагая революционную память SOCAMM

Похоже, монополия Nvidia на инновационные решения оперативной памяти для серверов искусственного интеллекта подходит к концу. По данным южнокорейских источников, AMD и Qualcomm активно работают над внедрением стандарта SOCAMM в свои будущие продукты. Цель — устранить ограниченный объём памяти, который стал препятствием в автономных ИИ-системах.

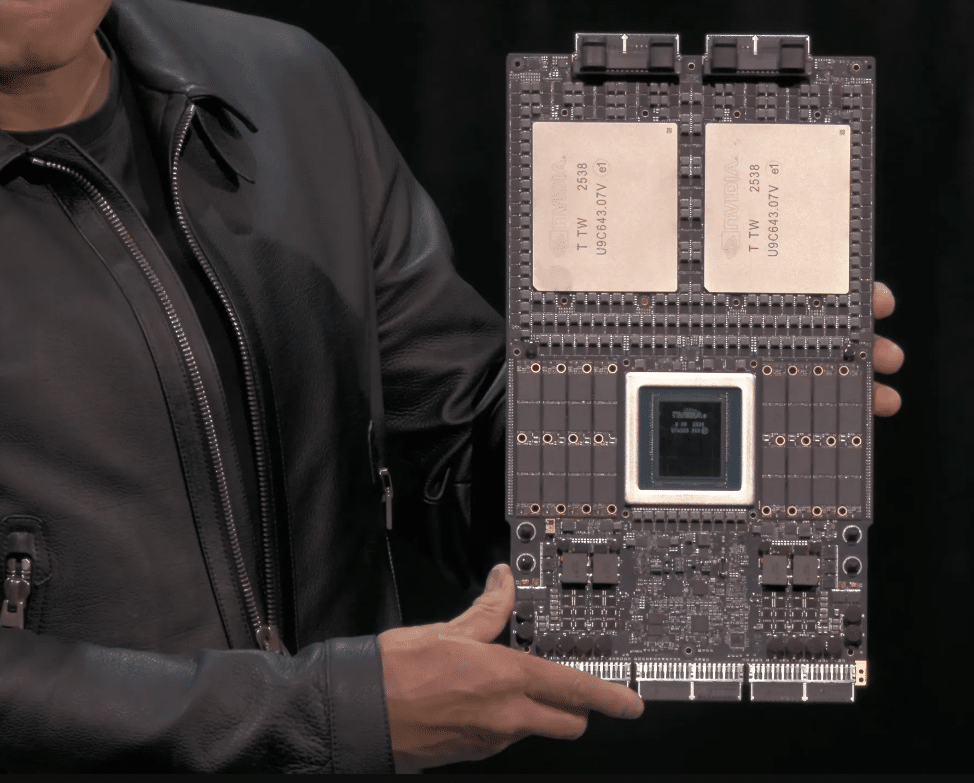

До сих пор технология SOCAMM воспринималась как «секретное оружие» от Nvidia. Это решение, основанное на энергоэффективных чипах LPDDR (традиционно используемых в ноутбуках и смартфонах), вносит ключевое изменение: модульность. В отличие от постоянно припаянной памяти LPDDR5X или дорогих стеков HBM, SOCAMM является съемным и масштабируемым, что делает его идеальным дополнением к сверхбыстрой памяти HBM для приложений, требующих хранения больших объемов данных.

Согласно отчету Hankyung, AMD и Qualcomm не намерены слепо копировать «зеленые» решения. Обе компании изучают концепцию конкретного квадратного модуля, в котором чипы DRAM расположены в два ряда. Ключевое инженерное отличие заключается в интеграции схемы управления питанием непосредственно в сам модуль памяти.

Этот подход имеет определенные преимущества:

– Стабильность на экстремальных скоростях: Регулирование напряжения происходит непосредственно рядом с микросхемами памяти, устраняя помехи и обеспечивая более высокую тактовую частоту.

– Упрощение конструкции: перемещение силовой части в модуль облегчает материнскую плату, снижая ее сложность и затраты на производство.

Почему все вдруг спешат принять этот стандарт? Ответ кроется в растущих требованиях к так называемым ИИ-агентам (то есть автономному искусственному интеллекту). Современные языковые модели требуют доступа к миллионам маркеров контекста в режиме реального времени. Память HBM хоть и не имеет себе равных по пропускной способности, но слишком дорога и имеет слишком малую емкость.

SOCAMM становится идеальным хранилищем кэша. Это позволяет оснастить один процессор терабайтами оперативной памяти, которая является достаточно быстрой и энергоэффективной, чтобы поддерживать в готовности гигантские базы знаний агентов ИИ. Поскольку Nvidia планирует внедрить SOCAMM 2 в свою будущую платформу Vera Rubin, этот шаг конкурентов сигнализирует о том, что к 2026 году битва за доминирование ИИ перейдет от вычислительной мощности к емкости и эффективности подсистемы памяти.

Что думает искусственный интеллект: Гонка за производительность ИИ явно вступает в новую фазу, где не только чистая вычислительная мощность, но и архитектура памяти становятся ключевым фактором. Внедрение модульных стандартов, таких как SOCAMM, могло бы значительно снизить затраты и повысить гибкость решений искусственного интеллекта, что в конечном итоге ускорит их развертывание.

Помните, что AMD далеко опережает Intel, поскольку вышли тесты нового короля игровых процессоров.