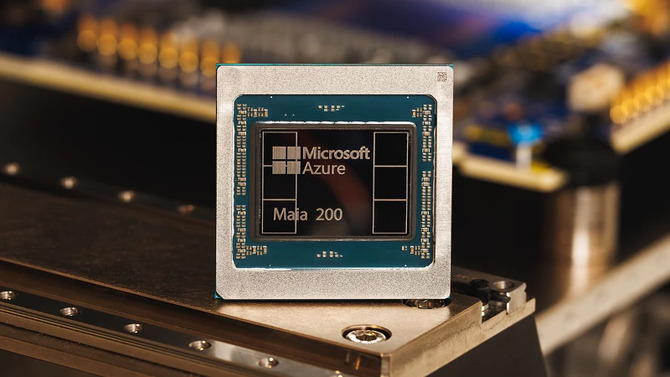

Microsoft Maia 200 — премьера ИИ-ускорителей, созданных для вмешательства в крупные модели, которые составят конкуренцию ТПУ от Google

В настоящее время на рынке ускорителей искусственного интеллекта доминирует компания NVIDIA, которая в больших масштабах предлагает ускорители B200 и B300. В то же время сектор становится все более специализированным, некоторые компании, создающие модели ИИ, начали разрабатывать собственные ускорители, адаптированные к потребностям и специфике своих моделей. Примером может служить Microsoft, которая в настоящее время представляет ускорители Azure Maia 200, которые призваны конкурировать, в частности, с чипами TPU от Google и Amazon Trainium.

Ускорители Microsoft Azure Maia 200 обеспечивают производительность FP4 в четыре раза выше, чем у чипов Amazon Trainium 3-го поколения, а производительность FP8 превосходит чипы TPU 7-го поколения от Google.

Ожидается, что NVIDIA N1 и N1X будут представлены позднее в этом квартале. Первые устройства появятся вскоре после этого

Ускорители Microsoft Azure Maia 200 изготовлены по технологическому процессу TSMC N3P (3 нм). Каждый чип содержит более 100 миллиардов транзисторов и имеет TDP 880 Вт. Системы используют память SRAM, интегрированную непосредственно в кремниевую структуру чипа, емкостью 272 МБ, а также работают с памятью HBM3E емкостью 216 ГБ и пропускной способностью 7 ТБ/с. Чип Maia 200 оптимизирован для вычислений низкой точности и обеспечивает производительность 10 145 терафлопс при точности FP4 и 5 072 терафлопс при точности FP8. При расчете в формате BF16 она достигает 1268 терафлопс. На практике это означает, что один чип Maia 200 способен обрабатывать самые крупные модели искусственного интеллекта сегодня, оставляя при этом резерв вычислительной мощности для еще более крупных моделей в будущем.

Китайские компании, занимающиеся искусственным интеллектом, используют лазейки в системе экспортного контроля США. Tencent арендует процессоры NVIDIA Blackwell за рубежом

В крупных вычислительных центрах искусственного интеллекта связь между чипами и узлами играет ключевую роль. В одном узле расположены четыре чипа Maia 200, соединенные прямыми некоммутируемыми каналами связи. Подсистема памяти Maia 200 основана на узких типах данных, специализированном механизме DMA, памяти SRAM, интегрированной непосредственно в кристалл, и специализированной структуре NoC (Network-on-Chip) для передачи данных с высокой пропускной способностью. Это позволяет локально хранить больше весов и данных модели, сокращая количество устройств, необходимых для запуска модели. В отличие от NVIDIA в поколении ускорителей Vera Rubin, Microsoft использовала общий стандарт Ethernet в соединениях между узлами. Речь идет о соединениях пропускной способностью 400 Гбит/с, осуществляемых по 28 каналам сети. Эти соединения также используют тесно интегрированную сетевую карту (NIC) и специальный транспортный уровень для данных.

| Microsoft Azure Майя 200 |

AWS Трениум 3 | Гугл ТПУ 7-е поколение |

|

| Технологический процесс | ТСМК Н3П | ТСМК Н3П | ТСМК Н3П |

| Производительность FP4 | 10 145 терафлопс | 2517 терафлопс | Нет доступной информации |

| Производительность FP8 | 5072 терафлопс | 2517 терафлопс | 4614 терафлопс |

| Производительность БФ16 | 1268 терафлопс | 671 терафлопс | 2307 терафлопс |

| Тип памяти | HBM3E | HBM3E | HBM3E |

| Объем памяти | 216 ГБ | 144 ГБ | 192 ГБ |

| Передача данных | 7 ТБ/с | 4,9 ТБ/с | 7,4 ТБ/с |

| Пропускная способность сети | 1,4 ТБ/с | 1,2 ТБ/с | 0,6 ТБ/с |

| TDP | 880 Вт | 700 Вт | 1000 Вт |

Intel и NVIDIA создают специальные процессоры Xeon с технологией NVLink для инфраструктуры искусственного интеллекта

Для сетей внутри и между стойками используются одни и те же протоколы связи с использованием транспортного протокола Maia AI, который обеспечивает плавное масштабирование узлов, стоек и кластеров ускорителей с минимальным количеством сетевых переходов. Эта унифицированная архитектура упрощает программное обеспечение, повышает гибкость рабочих нагрузок и поддерживает стабильную производительность. Это способствует снижению затрат на обслуживание инфраструктуры, что приводит к снижению показателя совокупной стоимости владения для всего серверного помещения с искусственным интеллектом. Кроме того, сами системы Maia 200 предлагают на 30% лучшее соотношение производительности и стоимости по сравнению с ранее использовавшимися системами. Кроме того, Microsoft подчеркивает, что благодаря передовой среде моделирования первые узлы Maia 200 можно было запустить в течение нескольких дней с момента поставки первых чипов, а время от создания первого физического чипа до полной реализации в дата-центре сократилось более чем вдвое по сравнению с другими аналогичными проектами центров обработки микросхем и искусственного интеллекта.

NVIDIA Vera Rubin Superchip — обзор платформы искусственного интеллекта, производительность которой в пять раз превышает производительность Грейс Блэквелл

Чипы Maia 200 будут использоваться в основном в инфраструктуре Microsoft для генерации синтетических данных и обучения с подкреплением для улучшения запатентованных моделей следующего поколения. Эти модели будут реализованы, среди прочего: в Microsoft Foundry (платформа искусственного интеллекта для создания и запуска моделей в Azure), а также в Microsoft 365 Copilot и связанных сервисах. В настоящее время узлы с чипами Maia 200 разворачиваются в Центральном регионе США, а следующим этапом станет запуск инфраструктуры в регионе US West 3 недалеко от Финикса, штат Аризона. В более долгосрочной перспективе планируется внедрение и в других регионах. В то же время Microsoft призывает исследовательские сообщества, разработчиков и широко понимаемые лаборатории искусственного интеллекта экспериментировать с моделями и рабочими нагрузками с использованием нового Maia SDK, который включает в себя: компилятор Triton, поддержку PyTorch, низкоуровневое программирование на NPL, симулятор Maia и калькулятор затрат, позволяющий заблаговременно оптимизировать эффективность вычислений.

Источник: Майкрософт