OpenAI запускает GPT-5.3-Codex-Spark на чипах Cerebras WSE-3. Это первая реализация за пределами экосистемы NVIDIA.

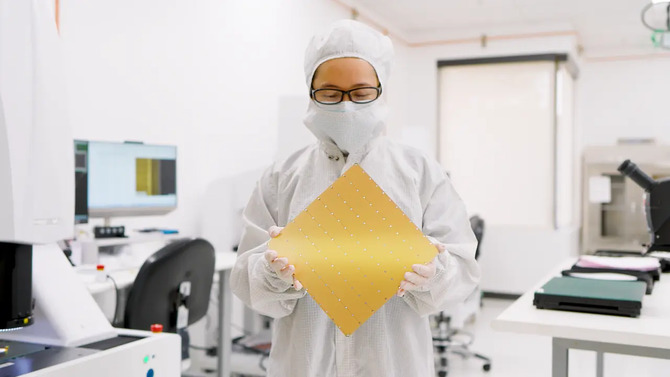

OpenAI только что выпустила GPT-5.3-Codex-Spark, облегченную версию своего флагманского инструмента кодирования, который работает на процессорах Cerebras Wafer Scale Engine 3 — микросхемах размером с обеденную тарелку, содержащих 4 триллиона транзисторов. Модель генерирует код со скоростью тысяча токенов в секунду, что в 15 раз быстрее, чем полный Кодекс GPT-5.3. Это первая производственная реализация OpenAI за пределами экосистемы NVIDIA.

OpenAI запускает первую производственную модель на архитектуре размером с кремниевую пластину Cerebras, достигая тысячи токенов в секунду при выполнении задач кодирования. Это чрезвычайно важное изменение в инфраструктурной стратегии гиганта искусственного интеллекта.

Антропный эксперимент стоимостью 20 000 долларов. Шестнадцать экземпляров Claude Opus 4.6 создали компилятор C за две недели.

Codex-Spark является результатом сделки на 10 миллиардов долларов между OpenAI и Cerebras, объявленной в январе 2026 года, всего через месяц после того, как генеральный директор NVIDIA Дженсен Хуанг публично раскритиковал бизнес-модель Сэма Альтмана. Как мы писали, когда 100-миллиардные инвестиции были приостановлены, отношения между двумя компаниями существенно охладились. NVIDIA так и не завершила разработку инфраструктурного пакета, обещанного в сентябре, и источники указали на недовольство OpenAI скоростью некоторых чипов NVIDIA в задачах вывода. Церебрас заполняет эту брешь.

Amazon MGM Studios запускает AI Studio. Программа бета-тестирования инструментов искусственного интеллекта в кинопроизводстве стартует в марте 2026 года.

Wafer Scale Engine 3 — третье поколение монолитной системы площадью 46 255 мм², содержащей 900 000 оптимизированных для искусственного интеллекта ядер и 44 ГБ памяти SRAM, интегрированной непосредственно в чип. В отличие от классических графических процессоров, использующих внешнюю память HBM, архитектура Cerebras устраняет узкое место в полосе пропускания, отсюда и впечатляющие результаты вывода: 2100 токенов/с для Llama 3.1 70B или 3000 токенов/с для gpt-oss-120B. Кодекс-Спарк достигает Только тысяч токенов в секунду, что OpenAI объясняет большей сложностью модели, но это всё равно результат, не имеющий аналогов у традиционных ускорителей. Эта технология уже доказала свою эффективность в тестах Mistral AI, которые в декабре 2025 года продемонстрировали преимущество Cerebras перед облачными решениями с использованием графических процессоров NVIDIA.

Клод против ChatGPT. Anthropic официально отказывается от модели рекламы в чат-ботах с искусственным интеллектом

Это не единственное отличие OpenAI от доминирующего поставщика. В октябре 2025 года компания подписала шестигигаваттное соглашение с AMD на процессоры Instinct, в ноябре заключила контракт на 38 млрд злотых с Amazon Web Services, а с февраля прошлого года в сотрудничестве с Broadcom и TSMC занимается разработкой собственных ASIC, производство которых в 3-нм литографии планируется начать в конце 2026 года. Параллельно NVIDIA приобрела технологию вывода Groq за $20 млрд, о чем мы сообщали в Декабрь. Это была попытка нейтрализовать конкурентов, которые предлагали 300–500 токенов/с по сравнению с 60–100 токенами/с для стандартных графических процессоров. Сейчас Cerebras работает в два-пять раз лучше, чем Groq до приобретения, и OpenAI имеет доступ к этой мощности благодаря многолетнему партнерству.

В Xcode 26.3 представлена модель контекстного протокола и встроенная поддержка автономных агентов искусственного интеллекта Claude и OpenAI.

Самое главное здесь — различать приложения. Codex-Spark не предназначен для конкуренции с полной версией GPT-5.3-Codex при решении долгосрочных задач, требующих глубоких рассуждений. Это инструмент для быстрой итерации, рефакторинга, мелких правок в коде, где важна немедленная реакция. OpenAI говорит прямо о два режима работыто есть совместная работа в реальном времени (Spark) и длительные аналитические задачи (полный Кодекс). Для разработчиков разница ощутима. Вместо того, чтобы ждать несколько секунд предложения автозаполнения, система реагирует практически мгновенно, что меняет ритм работы. Но не была ли точность принесена в жертву в погоне за скоростью? OpenAI предупреждает, что модель может потребовать проверки своих результатов.

Источник: Церебрас, OpenAI.