Приступают чат -боты, которые будут работать в 10 раз быстрее, чем присутствующие. Меркурий — первая серия DLLM, которая доказывает это

Почти все современные малые и крупные языковые модели основаны на одном и том же методе действий — почти, потому что новый только что дебютировал из лабораторий Intestion, который функционирует по -другому, хотя и довольно известно, но из другого сегмента такого называемого искусственный интеллект. Я говорю о семействе диффузии крупных языковых моделей (DLLM), называемой ртути. Вместо того, чтобы генерировать текст слева направо, выходные данные извлекаются из шума. Такой процесс имеет много преимуществ.

Mercury — это новое семейство диффузионных моделей крупных языков, которое было создано Insperation Labs. Новости основаны на том же способе действия, что и модели изображений и видео, такие как Midjourney или Sora. Скорость, потенциально меньшие галлюцинации и более низкие затраты являются основными преимуществами.

Openai представляет GPT-4.5. Крупнейшая модель ИИ теперь доступна для подписчиков CHATGPT Pro. Большие знания и естественные разговоры

Сегодняшние крупные языковые модели (LLM) являются авторегрессивными, поэтому — как уже упоминалось — они создают текст слева направо и делают все последовательно. Другой токен (фрагмент текста) генерируется только после того, как предыдущий был завершен. Этот метод широко используется, но требует значительных расчетных ресурсов для действий, которые в то же время увеличивают общие затраты. Это отличается от диффузионных моделей крупных языков (диффузия больших языковых моделей — DLLM). Они не должны генерировать текст по очереди, потому что выходные данные остаются — это позволяет гораздо быстрее работать и в то же время может способствовать снижению галлюцинаций путем исправления ошибок на протяжении всего процесса. Первые коммерческие модели ИИ из Instion Labs, которые основаны на этом методе действия, только что видели свет дня.

Claude 3.7 Сонет и Claude Code — новые продукты от антропного для программистов. Проще написание и проверка кода

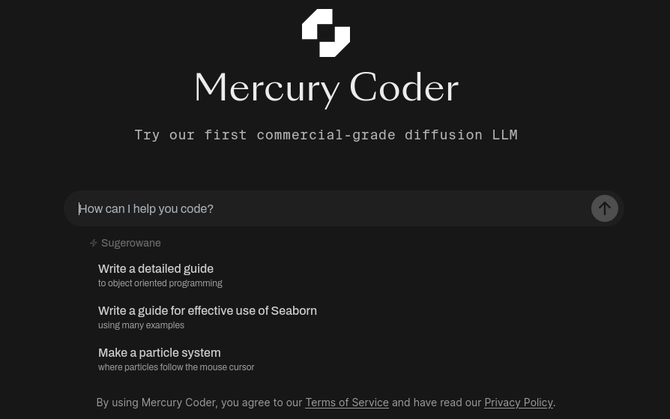

Mercury Coder, потому что эта семья DLLM состоит из двух просмотров: Mini и Small. Новости способны работать в 5-10 раз быстрее, чем текущий LLM. При использовании мини -акселератора Nvidia H100 Mercury Coder Coder он генерирует ответы на скорости более 1100 токенов в секунду — никакого конкурентного решения от Google, Anpropic, Deepseek или Openai просто не подходит. Модели адаптированы для генерации кода, и решение может быть проверено самостоятельно по этому адресу. На созданной платформе мы можем запустить код, который оказывается действительно очень полезным. Наконец, можно добавить, что «Labs» была создана профессорами из Стэнфордского университета, Калифорнийского университета, а также Университета Корнелла, и сотрудники из таких компаний, как Nvidia, Openai, Microsoft, Meta или из исследовательской лаборатории Google Deepmind.

Источник: Instion Labs, TechCrunch, Mobile Miniature: Rotepik/Pixabay