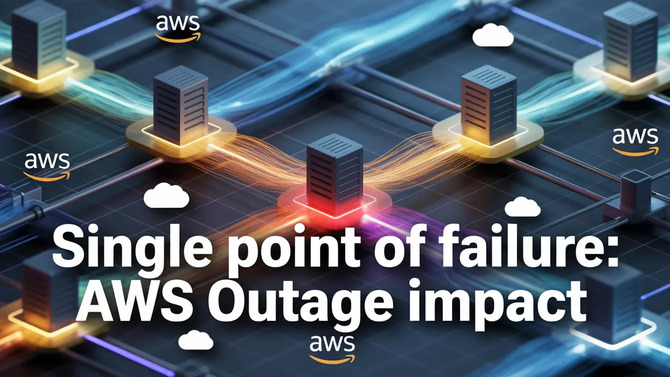

Пустая запись DNS испортила половину интернета. Amazon раскрывает шокирующую закулисную 15-часовую катастрофу для 3500 компаний и 17 миллионов пользователей

Крупнейшая в мире облачная платформа Amazon Web Services испытала сбои: Интернет замедлился, а затем практически остановился. Отключение электроэнергии, произошедшее в регионе US-EAST-1 (Северная Вирджиния) в четвертом квартале 2025 года, не было типичной проблемой перегрузки или простым аппаратным сбоем. Это был сложный сбой, который выявил критические зависимости и поставил на колени даже компании, которые могли похвастаться расширенной избыточностью.

Отключение AWS 20 октября — не случайный инцидент, а симптом системной проблемы: чрезмерная концентрация критической инфраструктуры в одном регионе превращает технические ошибки в глобальные катастрофы.

Juniper Research утверждает, что доходы операторов связи от API аутентификации увеличатся в двадцать раз в течение пяти лет

Представьте себе сценарий: один задержанный процесс, неудачное столкновение времени двух систем автоматизации и пустая запись в базе данных DNS. Эффект? 17 миллионов отчетов о сбоях, 3500 парализованных компаний в 60 странах и 15 часов хаоса. Это не научная фантастика. Именно так выглядел сбой Amazon Web Services 20 октября 2025 года. В регионе US-EAST-1, крупнейшем и старейшем хабе AWS в Вирджинии, возникла ошибка, которая звучит до абсурда просто. Две системы автоматизации попытались обновить одну и ту же запись DNS в неудачный момент, перезаписав друг друга. Британские банки обанкротились, Snapchat замолчал, миллионы умных устройств Ring и Alexa зависли. Это показывает нечто более важное, чем техническая неудача. Это обнажает мощные слабости в архитектуре, лежащей в основе современного Интернета.

Миллионы маршрутизаторов и коммутаторов Cisco подвергаются риску из-за активно эксплуатируемой уязвимости нулевого дня SNMP CVE-2025-20352

Суть проблемы заключалась в DynamoDB, распределенной базе данных NoSQL, которая является одним из столпов экосистемы AWS. Система управления DNS для этого сервиса состоит из двух элементов: DNS Planner, который отслеживает состояние сотен тысяч балансировщиков нагрузки и создает планы распределения трафика, и DNS Enactor, трех независимых экземпляров, работающих в разных зонах доступности и реализующих эти планы на Amazon Route 53. Это решение было разработано с учетом резервирования, но 19 октября в 23:48 по тихоокеанскому времени один из исполнителей столкнулся с необычными задержками, когда обновление записей DNS. В то же время DNS Planner продолжал генерировать новые планы, а второй Enactor быстро просматривал все конечные точки, реализуя более свежий план.

Северокорейские хакеры используют EtherHiding, скрывая вредоносное ПО в смарт-контрактах Ethereum и BNB Smart Chain

Когда второй Исполнитель завершил свою работу, он запустил процесс очистки старых планов, посчитав отложенный план первого Наставника устаревшим. Проблема в том, что первый Enactor, все еще скользящий по списку конечных точек, только что перезаписал новый план старым на региональной конечной точке DynamoDB. В процессе очистки этот «старый» план был удален, не зная, что он только что стал активным. Результат? Пустая DNS-запись для dynamodb.us-east-1.amazonaws.com и новые подключения к службе немедленно завершаются неудачно. Это классическое состояние гонки, ошибка синхронизации, которая возникает только в случае особенно неудачного совпадения. Произошел эффект домино. DynamoDB — это не просто база данных для клиентских приложений, это критически важная зависимость для других сервисов AWS, включая Identity and Access Management (IAM), отвечающих за аутентификацию. Когда IAM перестал работать, команды инженеров потеряли возможность входа в консоль AWS, что резко замедлило диагностику. Последующие волны затронули EC2, то есть систему Droplet Workflow Manager, которая управляет физическими серверами, размещающими экземпляры, и не смогла продлить аренду из-за отсутствия доступа к DynamoDB. После того, как сбой был локализован в 2:25 ночи по тихоокеанскому времени, DWFM пытался восстановить десятки тысяч аренды одновременно, входя в состояние застойного коллапса, ставя в очередь такой большой объем работы, что тайм-ауты истекали, прежде чем она могла быть завершена. Только выборочный перезапуск хостов DWFM после 4:14 утра восстановил возможность запуска новых экземпляров EC2, но распространение сетевых конфигураций через Network Manager продолжалось до 10:36. Полная нормализация произошла только в 13:50, почти через 15 часов после первоначальной ошибки.

Атака PixNapping на Android позволяет украсть коды 2FA без специальных разрешений путем манипулирования скриншотами

Downdetector, платформа мониторинга доступности веб-сайтов, зафиксировала беспрецедентный рост количества отчетов на 970%. выше дневной базы. Snapchat собрал почти 3 миллиона отчетов, Roblox — 716 тысяч, только розничная торговля Amazon — 698 тысяч. Проблемы коснулись британских банков (Lloyds, Halifax), налоговой службы HMRC, образовательных платформ (Instructure с 265 000 отчетов) и даже умных матрасов Eight Sleep, пользователи не смогли регулировать температуру кроватей. Географически лидерами стали США (6,3 млн заявок), Великобритания (1,5 млн), Германия (774 тыс.) и Нидерланды (737 тыс.). Основой для понимания масштабов катастрофы является положение региона US-EAST-1 в экосистеме AWS. Это старейший центр обработки данных компании, впервые запущенный в 2006 году, который используется по умолчанию для многих сервисов и инструментов. Даже теоретически «глобальные» приложения часто направляют туда потоки идентификационных данных, состояния сеанса и метаданных. Как сказал аналитик Ookla: «Региональная направленность означает, что даже глобальные приложения часто привязывают потоки идентификационных данных, состояния или метаданных к US-EAST-1. Когда региональная зависимость терпит неудачу, воздействие распространяется глобально, потому что многие «глобальные» стеки в какой-то момент проходят через Вирджинию»..

Польша входит в число наиболее уязвимых стран Европы. В отчете Check Point освещаются новые тактики киберпреступников и меняющиеся цели

Этот сбой не является единичным инцидентом. Вспомним CrowdStrike от июля 2024 года (ошибочное обновление заблокировало 8,5 миллионов машин с Windows), сбой Meta от 2021 года (ошибка BGP/DNS отключила Facebook на 7 часов) или проблемы Cloudflare и Akamai. Каждый из этих инцидентов раскрывает одну и ту же истину. Современный Интернет был построен на основе нескольких ключевых провайдеров и регионов, и отдельные точки отказа все еще существуют, несмотря на многомиллиардные инвестиции в резервирование. Как отметил эксперт по безопасности из CyberCube: «Это не вопрос аппаратного сбоя, который решается дублированием серверов. Это логические единичные точки отказа, ошибки в коде, конфигурации, процессах, которые требуют диверсификации слоев зависимостей». Реакция отрасли? Amazon отключил DNS Planner и DNS Enactor для DynamoDB по всему миру до тех пор, пока не будут устранены условия гонки и не добавлена защита от применения недействительных планов. В EC2 сейчас тестируют сценарии аварийного восстановления, в NLB ограничивают скорость, с которой система автоматически отключает вышедшие из строя серверы. Но это только половина решения. Регуляторы также реагируют. Европейский Союз принял Закон о цифровой операционной устойчивости (DORA), который налагает обязательства на поставщиков критически важной инфраструктуры ИКТ в отношении картирования зависимостей, тестирования устойчивости, отчетности об инцидентах и минимальной прозрачности после событий. Великобритания вводит аналогичный режим критически важных третьих сторон для финансового сектора. Эта правовая база сигнализирует об изменениях. Облако больше не рассматривается как частный бизнес провайдера, а становится системным компонентом экономической и национальной устойчивости.

Microsoft подтверждает эксплуатацию CVE-2025-10035 нулевого дня в GoAnywhere MFT хакерами с максимальным баллом угрозы 10,0

Для компаний, использующих облако, урок прост: невозможно поместить все на одну карту. Рассредоточение инфраструктуры по разным географическим регионам больше не вариант, а требование выживания. Во время проблем система должна действовать как корабль, сбрасывающий балласт: отключая менее важные функции (загрузка фото, рекомендации), чтобы ключевые (вход в систему, платежи) оставались на плаву. Игровые дни, моделирующие сбои DNS, базы данных или аутентификации, должны стать рутинной практикой. И хотя мультиоблачная среда кажется идеальным решением, стоимость и сложность репликации всего стека часто делают ее недостижимой для большинства организаций. Октябрьский сбой AWS доказывает, что эпоха «облака всегда работает» определенно закончилась. Будущее — это не ноль отказов, это проектирование с учетом ненадежности, когда отказ одного компонента не распространяется на всю экосистему, как пожар в сухом лесу. Как резюмировал Оокла: «Путь вперед — это не нулевой отказ, а воплощенный отказ, достигаемый за счет межрегионального проектирования, диверсификации зависимостей и дисциплинированной готовности к инцидентам, при этом нормативный надзор рассматривает облако как системный компонент национальной и экономической устойчивости».. US-EAST-1 только что написал следующую главу этого урока. Вопрос в том, приняла ли индустрия наконец это?

Источник: Amazon Web Services, Ookla Downdetector.