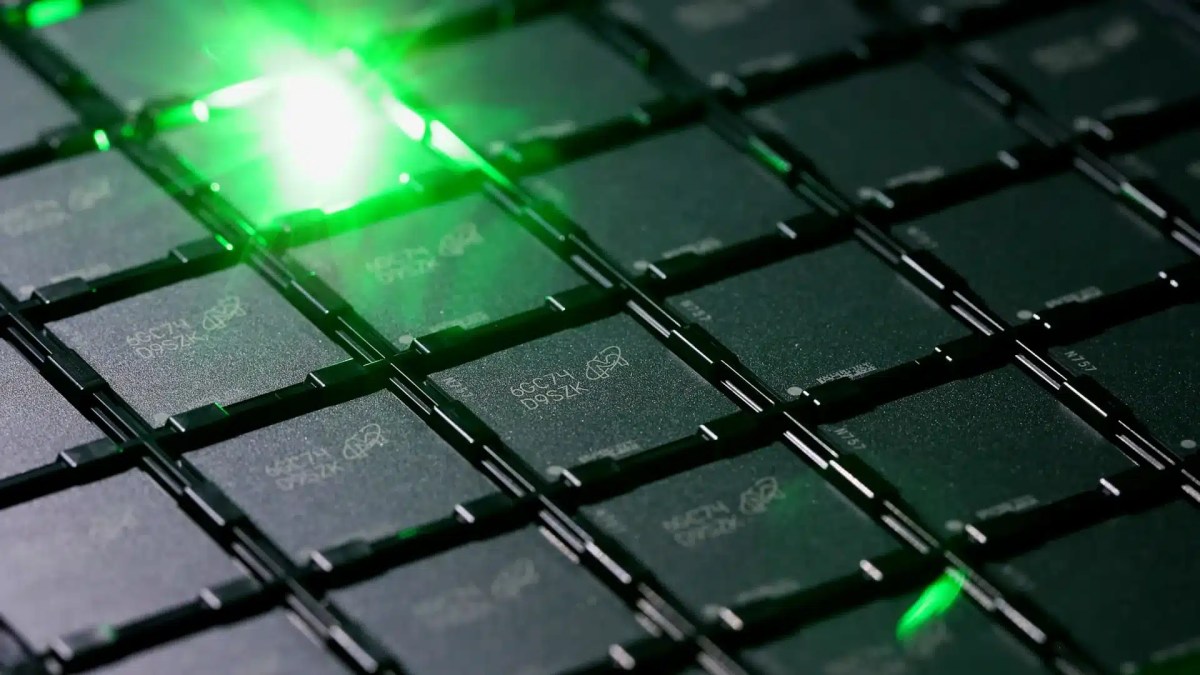

Ускорители искусственного интеллекта достигли предела скорости HBM, и проблема серьезнее, чем нехватка памяти

По отраслевым оценкам, современные ИИ-ускорители достигли такого этапа своего развития, когда пропускная способность интерфейса памяти становится барьером для дальнейшего масштабирования производительности.. Недостаток памяти или объема памяти в этом отношении отходит на второй план, и устранение этого барьера в основном зависит от разработчиков графических процессоров и больших языковых моделей.

По словам соучредителя Majestic Labs Ша Рабии, которого цитирует CNBC, хотя сами вычислительные ускорители за последние годы значительно продвинулись в скорости, их сопровождающая память не стала намного быстрее. Фактически именно производительность памяти сейчас ограничивает дальнейший рост скорости больших языковых моделей. Однако переход к логическому выводу увеличит потребность в еще большей емкости памяти, поэтому спрос на нее будет расти очень быстро. В любом случае, чем больше памяти имеет ИИ-инфраструктура, тем больше клиентов она может обслуживать в единицу времени. Основатель Nvidia Дженсен Хуанг также рассказал о необходимости увеличения производства памяти на выставке CES 2026. Он даже отметил, что покупатели решений игровых компаний, таких как видеокарты и консоли, «оскорбляются» со стороны AI-индустрии, поскольку нехватка памяти приводит к росту цен даже в этих смежных сегментах рынка.

Даже запланированный переход AMD и Nvidia на память типа HBM4 не решит полностью проблему пропускной способности.. Память в этом семействе по-прежнему ограничена с точки зрения количества каналов и высоты стека микросхем, не говоря уже о ширине интерфейса. Пропускная способность вычислений могла бы масштабироваться гораздо эффективнее, если бы не присущие HBM ограничения.. В этих условиях увеличивать количество вычислительных блоков в GPU не имеет смысла, поскольку память не сможет справиться с вычислительными нагрузками, связанными как с обучением, так и с выводом больших языковых моделей.

Методы упаковки чипов, доступные разработчикам компонентов, также выступают в качестве специфического ограничивающего фактора; в условиях высокого спроса емкость профилей сильно нагружается, что усугубляет дефицит высокоскоростной памяти и увеличивает затраты производителей.

На архитектурном уровне разработчики пытаются изучить альтернативы, такие как выполнение вычислений непосредственно на микросхемах памяти (PIM), увеличение плотности размещения микросхем в стеке памяти и использование усовершенствованных интерфейсов UCIe в многочиповых решениях, которые не только увеличивают эффективную пропускную способность, но и уменьшают задержку данных. Темпы дальнейшего масштабирования инфраструктуры ИИ будут зависеть от прогресса во внедрении более быстрой памяти.

HBM4 будет предлагать в полтора раза большую производительность, чем HBM3E, позволяя передавать до 2 терабайт данных в секунду по более широкой 2048-битной шине.. К 2027 году на арену выйдет память типа HBM4E, потенциально увеличивающая скорость передачи данных еще в 1,5 раза. Внедрение интерфейса CXL также должно способствовать повышению эффективности обмена данными между компонентами компьютерной системы. Что касается памяти, то переход на CXL обеспечит увеличение ее использования на 50%, а также снижение энергопотребления до 20-30%. Внешний вид новые методы размещения трехмерной памяти также должно способствовать повышению производительности и снижению энергопотребления.

`, // — БАННЕР 2 (Новости Google) — `

`, // — БАННЕР 3 (Viber) — `

` ); const randomIndex = Math.floor(Math.random() * Banners.length); document.getElementById(‘kaldata-random-banner’).innerHTML = баннеры(randomIndex); })();

Комментируйте статью на нашем форуме. Чтобы первыми узнавать самое важное, поставьте лайк нашей странице в Facebook и подпишитесь на нас в Google News, TikTok, Telegram и Viber или загрузите приложение по адресу Калдата.com для Android, iPhone, Huawei, Google Chrome, Microsoft Edge и Opera!