Micron представила модули оперативной памяти SOCAMM2 объемом 192 ГБ для серверов искусственного интеллекта

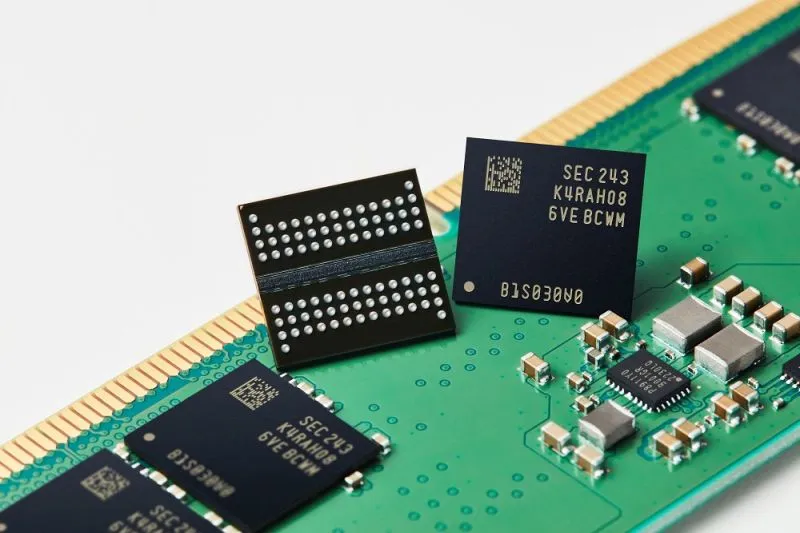

Micron Technology анонсировала компактный СОКАММ2 (Маленькие модули памяти со сжатием структуры) Модули оперативной памяти, предназначенные для использования в серверах для задач, связанных с искусственным интеллектом. Продукты на базе энергоэффективных чипов LPDDR5X имеют емкость 192 ГБ.

Первое поколение модулей SOCAMM было анонсировано в марте этого года. Их размеры составляют 14×90 мм. В производственном процессе используется DRAM 1β (пятое поколение класса 10 нм), а их емкость составляет 128 ГБ. Решения SOCAMM2 производятся с использованием самой передовой технологии Micron – DRAM 1γ (память шестого поколения класса 10 нм). По сравнению с исходными модулями емкость SOCAMM2 увеличена в полтора раза при сохранении тех же габаритных размеров. При этом энергоэффективность выросла более чем на 20%.. По сравнению с аналогичными решениями DDR5 RDIMM энергоэффективность повышена более чем на 66%. Заявлена скорость передачи данных до 9,6 Гбит/с на порт.

Таким образом, Micron утверждает, что технология SOCAMM2 превращает маломощную память LPDDR5X, изначально разработанную для смартфонов, в эффективные решения для центров обработки данных. В то же время модульная конструкция SOCAMM2 и инновационная технология штабелирования повышают удобство обслуживания и упрощают конструкцию серверов с жидкостным охлаждением.

Отгрузки образцов новой памяти уже начались. Micron активно участвует в разработке спецификации JEDEC SOCAMM2 и тесно сотрудничает с отраслевыми партнерами, чтобы вывести решения на коммерческий рынок. До сих пор модули SOCAMM использовались в NVIDIA GB300.